El día en que nos dimos cuenta de que teníamos un problema con Facebook

Facebook es hoy la base de datos personales más grande del mundo y de la historia de la humanidad, con 2.200 millones de usuarios activos. Crisis es la palabra más leve para describir esta semana la debacle que se cierne sobre la red social.

Muchos quieren ver a Facebook arder. También a Cambridge Analytica, qué duda hay. Hay una fila masiva para poner en duda el triunfo de Donald Trump, y otra en Europa para cuestionar el del Leave en el Brexit. Pero el gran problema que se ha revelado esta semana excede a una sola compañía, por más grande que sea; a un solo presidente, por más que sea el del país más poderoso del mundo; y a un proceso político en la Unión Europea. Estamos teniendo un problemón con nuestra democracia, la privacidad y la libertad de nuestros ciudadanos. Todo eso junto y mezclado.

Empecemos por el niño genio y su empresa. Facebook es hoy la base de datos personales más grande del mundo y de la historia de la humanidad, con 2.200 millones de usuarios activos. Crisis es la palabra más leve para describir esta semana la debacle que se cierne sobre Facebook, después de que The New York Times, The Guardian y The Observer publicaran sobre el uso indebido de datos personales de 50-60 millones de usuarios de Facebook por parte de Cambridge Analytica en el contexto de las elecciones estadounidenses que dieron ganador a Donald Trump. No sólo Facebook debería estar preocupado. Los detalles de la historia, lejos de matizarla, indican que estamos ante algo más que un problema que excede a una violación de contrato entre dos empresas o a una brecha de seguridad de datos. Nuestra vida en esta época está definida por una tendencia a largo plazo: consumimos y generamos información online, tanto en ámbitos personales como profesionales. Esto moldea los procesos informativos, de opinión pública y la participación en procesos democráticos en nuestras sociedades.

Christopher Wylie es un analista de datos, extrabajador de Cambridge Analytica, que reveló que utilizaron información personal tomada sin permiso de millones de usuarios de Facebook para construir un sistema que permitiera hacer perfiles individuales de votantes estadounidenses. El objetivo era dirigir hacia ellos mensajes específicos para influir en su voto, a través de técnicas de modelaje psicográfico y microtargeting.

Además de eso, la inacción de Facebook también ha sido noticia: el Observer tiene documentos que confirman que a fines de 2015 la red social sabía que se había producido una recolección de datos en una escala sin precedentes. En aquel momento, Facebook no avisó a sus usuarios y sólo se limitó a pedir a Cambridge Analytica que confirmara -con un check- que había borrado los datos. Carole Cadwalladr, la reportera del Guardian que publicó la noticia, dice que tanto Facebook como Cambridge Analytica amenazaron en varias ocasiones con demandar al periódico si publicaban la historia.

Hay algo más. El descubrimiento se produce unas semanas después de la imputación de 13 ciudadanos rusos por parte de Robert Mueller, el fiscal especial que investiga la injerencia rusa en las elecciones estadounidenses, quien también ha pedido los correos electrónicos de los empleados de Cambridge Analytica que trabajaron para la candidatura de Donald Trump. Mueller ha afirmado que los rusos utilizaron Facebook para perpetrar una guerra informativa contra los Estados Unidos.

Los datos y la guerra

Guerra de información, herramienta psicológica, propaganda, armas culturales, un "MI6 para contratar" (como describió a Cambridge Analytica otro exempleado). Si suena a metodología militar es porque lo era. SCL Elections, la compañía de la que nació Cambridge Analytica al recibir inversión por parte de Robert Mercer, se especializaba en "operaciones psicológicas" (spyops), que incluían la desinformación y la difusión de noticias falsas y rumores. El SCL Group, del que dependía SCL Elections, era un contratista privado que llevaba operaciones de elecciones y también de defensa. El objetivo de Mercer, republicano y donante de la campaña de Trump, era influir el voto de los estadounidenses en ese sentido.

"Estás jugando con la psicología de una nación entera en el contexto de unas elecciones", dijo Wylie. "Si puedes controlar todos los flujos de información alrededor de tu oponente, puedes controlar cómo se percibe el campo de batalla y entonces podrás influir en su comportamiento y reacciones", explicó.

La influencia de las campañas

Vamos a detenernos un momento en esto. Las técnicas de modelaje psicográfico tienen base científica. "Nuestra conducta es estable y predecible en el tiempo, y es posible hacer clusters de personalidad que encajan con nuestra conducta futura y se encuadran con nuestras preferencias por parejas, u opciones políticas, por ejemplo", explica Guido Corradi, psicólogo. Un estudio, por ejemplo, demostraba que se podían predecir tus ideas políticas en función de si te gustaban patrones gráficos de un tipo u otro.

Pero una cosa es estudiar perfiles y otra provocar o cambiar comportamientos. Jorge Galindo, sociólogo, dice que en voto y actitudes políticas (que en realidad es lo mismo que campañas) hay toda una literatura académica que indica que sus efectos no son determinantes, y estos estudios valen para campañas con modelaje de perfiles vía Facebook.

"Las campañas en Facebook tienen resultados pero no por Cambridge Analytica, sino por el propio Facebook, que permite clasificar por ciertos rasgos psicológicos", afirma Victoriano Izquierdo, fundador de Graphext, una empresa que trabaja con el análisis de datos de redes sociales. También él es escéptico de la influencia en votantes. "Un punto importante que revelan todas estas técnicas es que sobre todo nos manipulamos a nosotros mismos con nuestro sesgo de confirmación. La microsegmentación en redes lo potencia y estas empresas lo explotan", dice.

En 2014 Facebook publicó un estudio extenso con datos de sus usuarios en el que había experimentado sobre sus emociones y el efecto contagio. "Fue un estudio que con mucho esfuerzo logró un efecto muy pequeño", afirma Corradi, quien está seguro de que se trató de una prueba de concepto. O en otras palabras, Facebook mostrando a los anunciantes su poder derivado de su ingente base de datos.

Como otros experimentos hechos por Facebook en ocasión de elecciones, este estudio levantó muchas críticas por parte de expertos y comunidad académica por no haber informado a los usuarios. A raíz de la polémica, Facebook debió modificar los términos de su política de uso.

Cualquier desarrollador puede acceder a recoger datos mediante una app, no existe ninguna API especial para desarrolladores o un permiso extra que pudieran haber dado a Aleksandr Kogan, el psicólogo de Cambridge Analytica que modeló los perfiles.

Los académicos vienen advirtiendo desde hace años de los problemas relacionados con la privacidad en la metodología de estos estudios con herramientas en redes sociales. Este problema viene desde antes en las ciencias sociales, explica Galindo. "Es un standard en todo el mundo que en las encuestas los datos deben estar anonimizados. Lo que pasa es que Facebook es una versión en esteroides de ese mismo problema".

En redes sociales además se da una situación compleja donde la privacidad ya no depende solo de una persona. El concepto de privacidad interdependiente designa a esta situación donde tus amigos definen tu nivel de privacidad. Así Cambridge Analytica pudo obtener los perfiles de 50 millones de personas a partir sólo de 320.000 que dieron su consentimiento a través de la app.

Las preferencias políticas cambian menos que la personalidad a lo largo de la vida, dice Corradi. "Pero si tienes acceso a lo que dice la gente puedes acceder a una ventana de oportunidad para hablarles a los que no lo tienen muy claro, los indecisos. Esto lo hacía (Barack) Obama". Hay estudios que sugieren que los votantes conservadores son más propensos a compartir noticias falsas que el resto. Por eso expertos coinciden en que bajo ciertas condiciones, si el microtargeting apunta a un grupo relativamente pequeño, personas a las que sólo les falta una serie de estímulos para actuar, y la elección no se decide por muchos votos, la campaña puede ser decisiva. Recordemos que la victoria de Trump se definió por algo más de 40.000 votos de diferencia en tres estados.

Si es gratis, adivina quién es la mercancía

La historia de Facebook y su crecimiento es paralela al mito de creación de nuestra era de la información. Lo que comienza como una herramienta simple para conectar con amigos creada por un estudiante en su residencia universitaria ha ido transformándose. Se convirtió en una forma de registrarnos en otros sitios, en una publicación donde leer noticias y ver vídeos, en un servicio para saber si algún conocido estaba bien cuando había un terremoto, en una plataforma para adherirnos a causas. En algunos países y para muchas personas Facebook es internet a secas.

El gran logro de Facebook ha sido el de crear una plataforma compleja que fuese casi intuitiva para usuarios muy diversos, poner algoritmos a estudiar sus impulsos y gratificaciones, y hacerla tan masiva que pudo obtener rentabilidad, a través del conocimiento que tiene de sus usuarios.

Muchos se acuerdan del "Move fast and break things" (Muévete rápido y rompe cosas) pero también revelador es el "Privacy is no longer a social norm" (La privacidad ya no es una norma social). Esto dijo Zuckerberg al Guardian cuando, tras hacer más permisivas por defecto las opciones de privacidad de Facebook recibió una lluvia de críticas de usuarios enfadados.

Desde el comienzo, Facebook tuvo muy claro su modelo de crecimiento y negocio: vender publicidad ofreciendo la mejor información sobre sus usuarios. En una internet llena de extraños, mientras más seguros y en compañía de amigos nos sentimos, más compartimos, más comentamos y más fotos enviamos. Cada una de estas acciones significan clicks y variables que nos definen. La segmentación de usuarios es tan granular que sólo Facebook hoy puede ofrecer no sólo demografía sino intereses y perfiles a este nivel a clientes en todo el mundo.

Uno de los signos de que la publicidad de Facebook funciona tan bien es que hay una leyenda urbana que dice que Facebook "nos escucha". Lo que da más miedo que eso es que Facebook nos conoce tan bien por otras vías que realmente parece que nos escucha.

Una tormenta perfecta

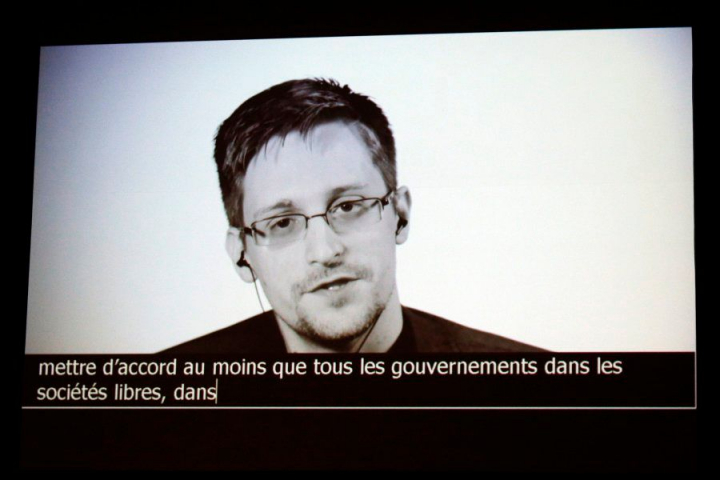

Entre 2013 y 2015 Edward Snowden nos abrió los ojos a una red de vigilancia sobre la población mundial por parte de las agencias de inteligencia de Estados Unidos en colaboración con otros países aliados. Fue a partir de entonces cuando la privacidad comenzó a ser incluida como una característica en productos y servicios. El poder de la explotación de los datos masivos, el derecho a la privacidad y la protección de los datos personales entraron en el ámbito de la conversación pública a nivel mundial.

Cambridge Analytica apareció en las noticias por primera vez en 2015, cuando The Guardian publicó que la campaña presidencial de Ted Cruz estaba usando perfiles psicológicos basados en datos de 30 millones de usuarios de Facebook, que habían sido obtenidos sin su permiso. Facebook en aquel momento se limitó a quitar los permisos sobre los amigos de usuarios.

En 2016, el referéndum del Brexit primero y luego el triunfo de Donald Trump en las elecciones de Estados Unidos tomaron por sorpresa a muchos, que se preguntaban qué influencia podían haber tenido las fake news en ello. Zuckerberg mismo hizo declaraciones tras la elección de Trump diciendo que pensar en ello era una "idea loca". Sin embargo, el mes siguiente anunció que estaban trabajando en una implementación de fact-checking para las noticias.

La interferencia del gobierno ruso en las elecciones de Estados Unidos en 2016 ha sobrevolado el mandato de Trump hasta el día de hoy. Hace unas semanas, Robert Mueller, fiscal especial a cargo de la investigación, imputó a 13 ciudadanos rusos y pidió los emails de los empleados de Cambridge Analytica.

Esta semana también se han conocido las declaraciones de Sandy Paralikas, jefe de producto de Facebook entre 2011 y 2012, que declaró que la compañía tardó dos años y medio en actuar a pesar de haber sido advertida en el caso de Cambridge Analytica. Paralikas, a petición del una comisión del Parlamento británico, declaró que Facebook permitía a los desarrolladores acceder a datos de usuarios que no lo habían autorizado explícitamente. "La compañía se enfocaba tanto en el crecimiento, que no prestaba atención a otros problemas".

La tibieza de Facebook en torno a la seguridad de los datos ha sido notable. Esta semana, después de conocerse el robo de datos de Cambridge Analytica, Zuckerberg ha declarado que no se ha producido una brecha de seguridad, aunque sí una "brecha de confianza", porque Cambridge Analytica hizo un mal uso de los datos.

Hace dos años, el equipo de seguridad de Facebook advirtió que había agentes rusos tratando de robar credenciales de periodistas. Facebook se limitó a reportarlo al FBI. Un año después y en medio de las noticias sobre la injerencia rusa, Facebook dio a conocer que un grupo ruso había pagado 100.000 dólares por 3.000 avisos destinados a votantes estadounidenses. El anuncio pareció aún más insignificante el mes siguiente, en octubre de 2017, cuando el investigador Jonathan Albright reveló que publicaciones pertenecientes a seis cuentas de propaganda rusa habían sido compartidas 340 millones de veces.

Facebook ha sido acusado de difundir propaganda contra los Rohingya en Myanmar y por promover el brutal liderazgo de Rodrigo Duterte en Filipinas. En Sri Lanka le denuncian de propagar mensajes de odio hacia la minoría musulmana.

Alex Stamos, el jefe de seguridad de Facebook, renunció tras el escándalo esta semana, por diferencias con la dirección en la forma de gestionar la actividad rusa en la plataforma. El directivo era partidario de investigar a fondo la responsabilidad de Facebook en torno a las noticias falsas.

Una plataforma global y un espacio público

François Chollet, investigador de Google especializado en deep learning, considera que el problema con Facebook consiste en el consumo como un vector de control psicológico. Explica que el mundo está siendo definido por dos tendencias a largo plazo, por un lado que nuestras vidas consumen y generan información online, y por otro que la inteligencia artificial está aprendiendo cada vez más. Esas dos tendencias se unen al nivel de los algoritmos que dan forma a nuestro consumo digital. Algoritmos que son opacos y que deciden qué artículos leemos, con quiénes estamos en contacto, qué opiniones nos alcanzan. Facebook puede medir todo sobre nosotros y controlar la información que consumimos, y puede hacerlo de forma simultánea como nadie.

Los whistleblowers suelen sentir una fuerte llamada ética. La de Wylie se resume en lo que entendió usando microtargeting en sus campañas: "En vez decir lo que piensas en la plaza pública y dejar que la gente venga y se acerque a ti, y tenga esa experiencia compartida, lo que tú haces es susurrar al oído de todos y cada uno de los votantes. Le dices una cosa a uno y otra al siguiente. Estamos poniendo en riesgo de fragmentación de la sociedad en una manera en la que ya no tengamos experiencias compartidas ni entendimiento compartido. Si no tenemos eso, ¿cómo podemos ser una sociedad en funcionamiento?"

Después de ver lo que está sucediendo, es fácil sucumbir a impulsos como el de #deleteFacebook, tuiteado (también) por Brian Acton, el mismo fundador de WhatsApp (empresa comprada por Facebook) e Elon Musk, que borró las páginas de Tesla y SpaceX. Pero la vida no es tan simple y el dilema no es individual.

El problema de ser una democracia que depende de anuncios políticos microsegmentados y adaptados específicamente para pequeños grupos de la población va mucho más allá de Cambridge Analytica. El mejor sistema para esto es el mismo Facebook y por eso es que vale 500.000 millones de dólares. En el sistema de anuncios de Facebook no hay restricciones para enviar anuncios a personas basadas en cualquier atributo con el que pueda ser target, como hombres mayores de 65 años que estén interesados en la Asociación Nacional del Rifle y que tengan "probabilidades de comprometerse en contenido político conservador". Expertos como Zeynep Tufekci, investigadora de la Universidad de Princeton, alertan desde hace algunos años de esta situación, diciendo que estos nuevos métodos son efectivos en manipular a la gente y que los científicos sociales entienden cada vez más que mucha de nuestra capacidad de decisión es irracional y emocional.

Mark Zuckerberg tardó unos días pero finalmente salió a disculparse y anunció que tomarían medidas. Medidas que no parecen ir en la dirección de cambiar sustancialmente la situación. En una entrevista con el New York Times, le preguntaron por su modelo de negocio y dijo que es importante "tener un servicio que la gente pueda permitirse. Mucha gente, pasado los primeros mil millones, no pueden pagar mucho. Por eso es importante seguir teniendo un modelo gratuito financiado con anuncios".

Ante este escándalo, Facebook enfrenta una situación delicada. El argumento de que siempre fue honesto y no ocultó nada con respecto a cómo los datos podían terminar en manos de los desarrolladores puede ganar una batalla pero perder la guerra. Si usuarios y entidades reguladoras deciden que Facebook no hizo nada fuera de lo normal, que esta es la manera en que funciona la compañía, pueden terminar decidiendo que esto no está bien. Vera Jourova, la comisaria de Justicia, Consumidores e Igualdad de la Unión Europea, ha dicho que el abuso de los datos personales, si se confirma, no es aceptable.

Cuando tu plataforma se transforma en la compañía responsable de los datos personales y de la información que reciben miles de millones de personas en todo el mundo, probablemente el problema ya tenga una dimensión pública (y trasnacional).

Están en juego los procesos democráticos en una era en que la realidad está profundamente mediada por la tecnología, y debemos pensar colectivamente qué mecanismos defienden nuestros derechos fundamentales y nuestra democracia antes de que sea demasiado tarde. Hablamos de algo más que un debate interesante: es una realidad que está afectando a vidas humanas en todo el planeta.