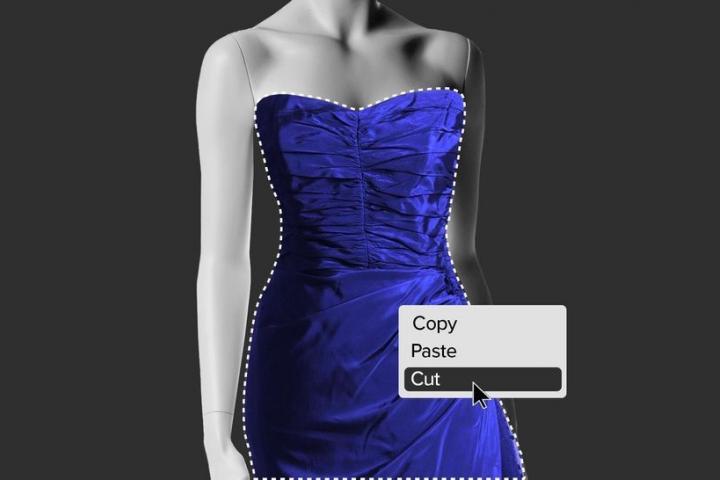

Una nueva tecnología 'deepfake' está desnudando digitalmente a miles de mujeres en internet

Los desnudos generados por esta inteligencia artificial son escalofriantemente realistas.

Una página web promete “hacer realidad los sueños de los hombres”. Los usuarios solo tienen que subir una foto de cualquier mujer vestida y, en cuestión de segundos, la inteligencia artificial las desnuda gratis. Con esa premisa, se ha convertido en una de las herramientas de tecnología deepfake más poderosas que se han creado.

Es una tecnología mucho más avanzada que la difunta aplicación DeepNude que se hizo viral en 2019. Esta nueva página web ya ha recibido más de 38 millones de visitas en 2021 y se ha convertido en un rincón misógino “secreto” de internet. El HuffPost no va a mencionar el nombre de la página web para evitar darles publicidad, pero se ha puesto en contacto con su proveedor de hosting, IP Volume Inc., y este ha decidido dejar de ofrecerle sus servicios. Sin embargo, la web ha tardado menos de un día en encontrar un nuevo proveedor, como suele ser el caso con las páginas denigrantes.

La web, que fue lanzada en 2020, explica que ha desarrollado sus propios algoritmos de traducción de imágenes mediante inteligencia artificial con función de aprendizaje profundo (deep learning) para “desnudar” cuerpos de mujeres. Sus creadores también presumen de que su tecnología es tan vanguardista que no existe mujer en el mundo, independientemente de su raza o nacionalidad, que esté a salvo de ser desnudada digitalmente. Eso sí, no funciona en cuerpos de hombre. Al probar la tecnología con un hombre cisgénero, la aplicación lo desnuda creándole pechos y vulva.

Con mujeres y personas de apariencia femenina, en cambio, los resultados son impactantemente realistas, sin defectos ni pistas visuales que ayuden a deducir que es un deepfake, es decir, una imagen creada sintéticamente. El potencial que tiene esta herramienta para hacer daño es inmenso. Cualquier tipo sin escrúpulos con ganas de vengarse de su ex puede ahora “desnudarla” y publicar los resultados como si fueran fotos reales filtradas. “Santa María, madre de Dios”, comenta un usuario, encantado con los “increíbles” resultados, en un foro online de hombres aficionados al porno deepfake. “Nunca había visto algo así. ¡El futuro hoy!”.

El apabullante éxito de esta web deja al descubierto la aciaga y cada vez más peligrosa realidad de ser una mujer en internet a medida que la tecnología deepfake sigue avanzando sin cortapisas. Las mujeres ya sufrían que las insertaran digitalmente en vídeos porno y que las desnudaran sin su consentimiento a través de tecnologías similares, pero menos avanzadas. El problema de esta tecnología fuera de control es que conforme sus resultados sean vuelven más realistas, las app también se están volviendo más accesibles.

Las víctimas del porno deepfake, que son casi exclusivamente mujeres y niñas, tienen pocos recursos legales para solucionar un problema que les cambia la vida por completo. Y aunque la página web asegura que no almacena ninguna imagen, sí que genera hipervínculos para cada foto editada, por lo que cualquier usuario puede subir una foto de cualquier mujer y difundirla en internet o consumirla en privado.

No se sabe quién está detrás de esta web, cuyas descripciones están plagadas de errores de sintaxis y faltas de ortografía. Tampoco se conoce su país de residencia o su nacionalidad. Los operadores no han respondido a las múltiples peticiones de entrevista de la edición estadounidense del HuffPost. El mes pasado, Estados Unidos fue el país que más tráfico generó en la página web, seguido de Tailandia, Taiwán, Alemania y China. Los medios y canales que publicaron tutoriales para utilizar la herramienta mostraban fotos del antes y el después de mujeres asiáticas, exclusivamente.

Pese al inmenso daño que esta y otras herramientas suponen para las mujeres (y para todo el mundo), las autoridades han hecho entre poco y nada por intervenir. Los legisladores de Estados Unidos han mostrado escaso interés en los deepfakes más allá de su potencial para provocar caos político. Las empresas que gestionan las redes sociales a menudo tardan en responder a las quejas sobre el contenido pornográfico no consentido, real o falso, que se difunde en sus plataformas, y no suelen asumir ninguna responsabilidad por ello.

Las fotos y los enlaces a este nuevo nudificador sin rival se han difundido en Twitter, Facebook, Reddit, Telegram y otras plataformas, tanto en canales públicos como en canales privados.

“Es una situación muy muy triste”, comenta Henry Ajder, experto en tecnología deepfake del Reino Unido. “La sensación de realismo ha mejorado una barbaridad”, añade, y señala que esta tecnología ya se utilizaba con las mujeres de a pie, no solo con famosas, desde hace tiempo.

“La inmensa mayoría de las personas que utilizan estas herramientas las aplican a sus conocidas”, explica Ajder.

No hay nada que frene a los dueños de esta página web o a sus usuarios de sacar provecho de las incontables mujeres a las que humillan. La página web no está escondida en la dark web, ni siquiera deslistada del índice del motor de búsqueda de Google. Está abierta a todos los públicos y anima a sus usuarios a promocionarla en sus redes sociales.

Una razón clave de su crecimiento exponencial parece ser su política de colaboración, por la cual los usuarios reciben recompensas cuando comparten una foto y otro usuario la abre. A los usuarios solo se les permite nudificar gratis a una mujer cada dos horas, pero pueden pagar con criptomonedas para cancelar la espera o conseguir el derecho de generar hasta 100 fotos sin restricciones a través de las mencionadas recompensas.

Esto ha incentivado a miles de personas para promocionar la página web por todo internet a través de hipervínculos a las fotos de las mujeres que han elegido nudificar sin su conocimiento ni consentimiento: compañeras de trabajo, amigas, compañeras de clase, exparejas, vecinas, desconocidas... Pero esto no solo atrae más tráfico a su página, sino que también explota todavía más a sus víctimas. Hay cientos de hilos en Reddit creados específicamente para compartir tus enlaces y pinchar en los enlaces de los demás. “Ayúdame y te ayudo”, titula uno de los usuarios. ”¿Quieres ver a tu amiga desnuda?”, se ofrece otro forero. “De nada, chavales”, escribe un tercer usuario.

Desde una perspectiva empresarial, esta política de colaboración ha demostrado ser una estrategia de crecimiento muy efectiva, pero tiene una vulnerabilidad evidente: Twitter, Facebook, Reddit, Telegram y otras redes sociales pueden capar en cualquier momento la URL de la página. Sería una medida muy simple que funcionaría de inmediato. Sin embargo, hasta ahora solamente Facebook ha dado el paso tras la petición formulada por la edición estadounidense del HuffPost.

“La que se quiera considerar una plataforma responsable debe adoptar medidas de ese estilo”, corrobora Mary Anne Franks, profesora de Derecho en la Universidad de Miami y presidenta de la Cyber Civil Rights Initiative. Ella también está impactada por la permisividad que han mostrado estas grandes compañías durante tanto tiempo.

“Es su responsabilidad ser proactivos en la búsqueda y detección de esta clase de amenazas antes de que se conviertan en problemas”, añade Franks. “No deberíamos ser los particulares o los periodistas los encargados de señalar el problema”.

Un portavoz de Reddit declara que las “políticas del foro prohíben la pornografía involuntaria de todo tipo, incluidos los deepfakes”. Y añade: “Seguiremos eliminando todo aquel contenido que viole nuestras políticas y a los usuarios involucrados”. Twitter también elimina de su web el contenido que infringe sus políticas, según un portavoz, pero todavía se pueden encontrar muchos de los enlaces a estos deepfakes en ambas plataformas y no hay nada que impida a los usuarios seguir publicando más.

Telegram no ha querido hacer declaraciones.

Google asegura que elimina las páginas web de su índice del motor de búsqueda cuando lo impone una ley. “Para las víctimas involuntarias de pornografía sintética tenemos una política por la que puedes solicitar la retirada de páginas web de Google Search”, explica un portavoz de la compañía. “Para afrontar estos desafíos a gran escala, diseñamos nuestros sistemas para que promocionen información de calidad y eviten el contenido sensible o explícito a no ser que alguien lo busque directamente”.

Las plataformas tecnológicas con sede en Estados Unidos gozan de inmunidad contra casi cualquier contenido generado por sus usuarios gracias al artículo 230 de la Ley de Decencia en las Comunicaciones, aprobada hace varias décadas y ya desfasada desde hace tiempo. En consecuencia, estas compañías pueden decidir de forma independiente el contenido que quieren eliminar y el que no. Aunque casi todas ellas tienen políticas que prohíben expresamente el acoso sexual (en algunos casos, se especifica también el porno deepfake), lo cierto es que la aplicación deja bastante que desear. Tal y como pueden afirmar muchas mujeres, probablemente te resulte mucho más sencillo eliminar contenido por motivos de copyright que por pornografía involuntaria.

Y mientras los gigantes de las redes sociales han permitido la expansión de la página web nudificadora, hay dos compañías tecnológicas que están haciendo lo posible por mantenerla abierta y a pleno rendimiento: Ab Stract —su nuevo proveedor de hosting finlandés—, y TLD Registrar Solutions —un dominio que opera fuera del Reino Unido.

Ambas compañías tienen libertad para decidir si hacen negocios con una página web que elimina digitalmente la ropa de las mujeres sin su consentimiento. Aun así, si alguna de ellas decidiera dejar de colaborar con esta empresa, como hizo IP Volume, solo sería una solución temporal, ya que no tardarían en encontrar otros proveedores y dominios.

TLD Registrar Solutions no ha accedido a conceder una entrevista a este medio y Ab Stract no ha respondido.

En un pasado no muy lejano, crear una imagen realista de una mujer desnuda habría costado un tiempo considerable, además de la destreza y el esfuerzo necesarios. A día de hoy, cualquiera puede hacerlo gratis, y lo están haciendo millones de personas. Esto significa que cualquier niña o mujer con imágenes públicas (en TikTok, en Instagram, en el anuario escolar...) es vulnerable. Y conforme la página web se agiganta, está ganando mucho dinero que probablemente sirva para mejorar todavía más su inteligencia artificial.

“A medida que estas aplicaciones se vuelvan más sofisticadas, será imposible diferenciar entre un desnudo real y un desnudo artificial”, advierte Franks, que está elaborando un borrador sobre legislación penal contra “el fraude de suplantación digital” que castigaría tanto a quienes crean estas imágenes como a quienes las distribuyen, y actualizaría el artículo 230 de la Ley de Decencia en las Comunicaciones.

Las víctimas de porno vengativo y otras imágenes pornográficas no consentidas han perdido empleos, relaciones y reputaciones. Muchas de ellas se suicidaron. Ya da igual si son imágenes reales o no: están creando por sí mismas una realidad con la que estas víctimas tendrán que vivir.

La página web nudificadora va camino de superar su récord de tráfico mensual. Con la indiferencia de las grandes compañías tecnológicas y la carencia de un marco legal que asigne responsabilidades, la pregunta no es cómo se ha hecho tan popular esta herramienta, sino cómo no iba a lograrlo con tantas facilidades.

Este artículo fue publicado originalmente en el ‘HuffPost’ Estados Unidos y ha sido traducido del inglés por Daniel Templeman Sauco.