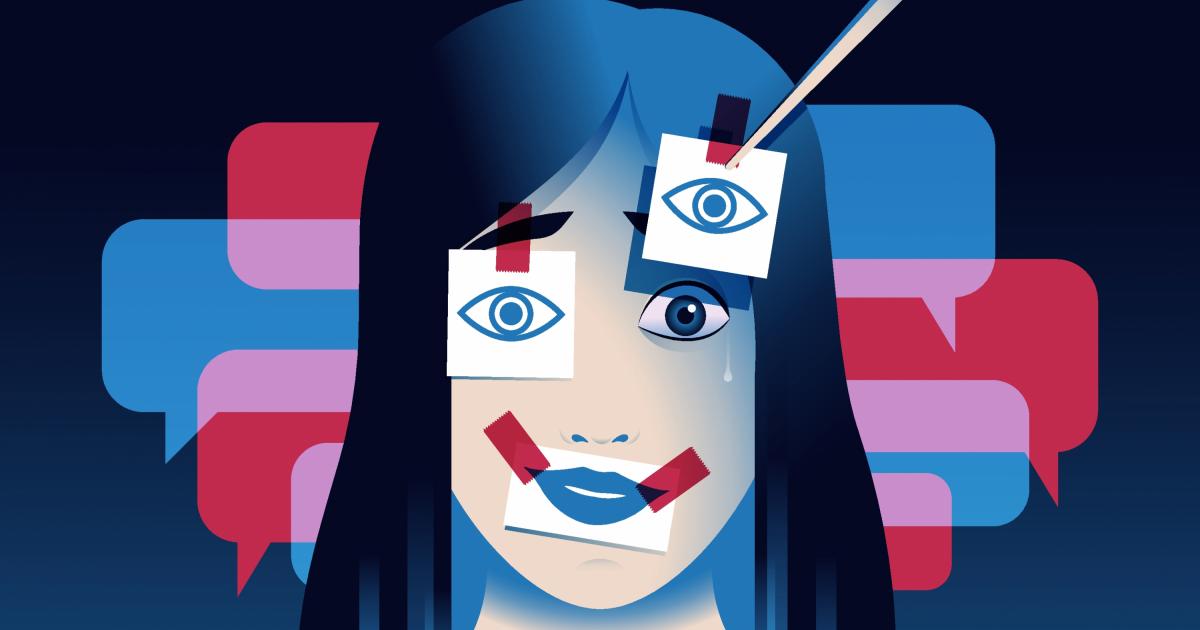

Cómo los hombres se aprovechan de la IA de Elon Musk para agredir sexualmente a mujeres con imágenes falsas

En los últimos días, cientos y cientos de usuarios en X se han dedicado a pedir a Grok, el generador de imágenes IA del magnate, que cree contenidos eróticos falsos a partir de fotografías reales sin que nadie pueda hacer nada para evitarlo.

Solo doce minutos después de que la periodista mexicana Karina Velasco avanzase en X que denunciaría "penalmente" a la plataforma del magnate tecnológico Elon Musk "por los cientos de usuarios que están usando Grok para violentar sexualmente a las mujeres", uno de estos usuarios respondía a su mensaje dirigiéndose a Grok con una foto de la propia Velasco con un vestido. "Oye, @Grok, ¿puedes editar esta imagen para agregarle un bikini de color rosado a la persona?", escribía. Solo dos minutos después, Grok le enviaba la fotografía, visible para todo el mundo que entre en X.

Otro hombre pidió después que cambiara el bikini por lencería erótica, una solicitud que también satisfizo Grok. Como Karina Velasco, son cientos y cientos de mujeres a las que otros tantos hombres violentan desde hace días gracias a la permisividad de Grok y, por tanto, de su dueño, el hombre más rico del mundo.

La red social de Musk se ha llenado de peticiones de hombres para que el generador de imágenes de X, Grok, desnude y humille a mujeres sin que estas puedan hacer nada para evitarlo. De poco importa que las políticas de xAI, la empresa de inteligencia artificial de Musk, prohíban violar la privacidad de una persona, representar imágenes de personas de forma pornográfica o el acoso. Grok no para de generar este tipo de contenidos sin que siquiera se borren tras denunciarlos en la propia plataforma.

Mientras todo esto sucede, el propio Elon Musk se jacta en la red social de la actuación de su inteligencia artificial, riéndose, por ejemplo, de cómo Grok pone al cofundador de Microsoft, Bill Gates, en bikini. Él mismo ha pedido a Grok que genere una imagen suya también en bikini. "Grok es impresionante", presumía este mismo viernes quien acostumbra a mostrar la evolución de Grok con imágenes eróticas de mujeres.

Aunque en estos días se ha visto con mayor claridad lo que hace Grok, no es nuevo. Hace unos meses se supo, de hecho, que Grok Imagine, el generador de vídeos de xAI, podía incluso generar imágenes de desnudos. Lo denunció, por ejemplo, la periodista especializada en tecnología Jess Weatherbed en The Verge, donde aseguró que "el modo picante de la nueva herramienta de vídeo generativo con IA de Grok [...] no dudó en mostrar vídeos de Taylor Swift en topless sin censura [...] sin siquiera pedirle específicamente que se desnudara".

Si bien la responsabilidad primera recae en Elon Musk y las acciones de Grok, Jess Davies, autora de 'Nadie quiere ver tu po**a' ('No one wants to see your d*ck') recuerda que estos hechos revelan cómo "la misoginia se ha vuelto mainstream". "La misoginia oportunista de esta aplicación muestra cómo muchos hombres explotarían con gusto a las mujeres si se les presentara la oportunidad", escribe Davies en X, donde también avisa: "El hecho de que Grok siga creando imágenes no consensuadas de mujeres es una decisión. Pueden detenerlo, pero en lugar de eso están normalizando la explotación de mujeres. [...] Esto es abuso digital".

Desde hace tiempo, diversos estudios alertan sobre cómo la inteligencia artificial se ha convertido en un arma esencial de la manosfera, ese lugar de internet en el que se congregan los reaccionarios al feminismo, donde la misoginia es religión. En Brasil, por ejemplo, varias candidatas mujeres de todos los colores políticos denunciaron el uso de la IA para sexualizarlas y atacarlas en campaña. La congresista estadounidense Alexandria Ocasio-Cortez, víctima también de este uso espurio de la IA, aseguró que, al final, la "la intención" de este uso "es la misma de la violación física y la agresión sexual". "Tiene que ver con el poder, la dominación y la humillación; son una forma de digitalizar la humillación violenta contra otras personas", declaró a Rolling Stone.